[핵심 머신러닝] 정규화모델 1(Regularization 개념, Ridge Regression)

이 게시글은 김성범 교수님의 유튜브 강의를 정리한 내용입니다.

내용과 사진의 각 출처는 김성범 교수님께 있음을 미리 알립니다.

해당 게시글 강의 영상: https://www.youtube.com/watch?v=pJCcGK5omhE

[핵심 머신러닝] 정규화모델 1(Regularization 개념, Ridge Regression)

좋은 모델이란?

- 현재 데이터(training data)를 잘 설명하는 모델

- Explanatory modeling

- 미래 데이터(testing data)에 대한 예측 성능이 좋은 모델

- Predictive modeling

현재 데이터(training data)를 잘 설명하는 모델

= traing error를 minimize 하는 모델

MSE(traning) = (Y-Y^)^2

기본적인 통계책에 이에대한 내용이 잘 설명되어있습니다.

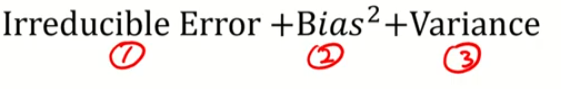

우리가 모델로서 할 수 있는것은 바이어스가 베리언스를 줄이는 것.

빨간 부분을 정답이라고 한다.

정답을 잘 맞추는 것은 베리언스가 적음

1. 분산과 바이어스가 적음

2. 분산은 흩어져있고 바이어스는 괜찮음

3. 분산은 좋음 바이어스가 조절되어야함

4. 둘 다 안좋음

회귀계수의 점추정 량? -> 최소제곱법으로 구한 것

알려지지 않은 파라미터에 대한 값

정규화 개념

1,2,3 중에 어떤 모델이 잘 설명이 되어있는지 확인해보자.

정답은 없지만, 관계에 대한 설명

차수가 커질수록 train error는 0으로 수렴

High Bias

트레인 에러

테스팅 에러 둘 다 크다.

따라서 왼쪽 파란색 박스에 해당

3번은 베리어스가 큼

트레인 에러 작다

테스팅 에러 크다

따라서 오른쪽 파란색 박스에 해당

따라서 2번이 적당히 좋은 모델이다.

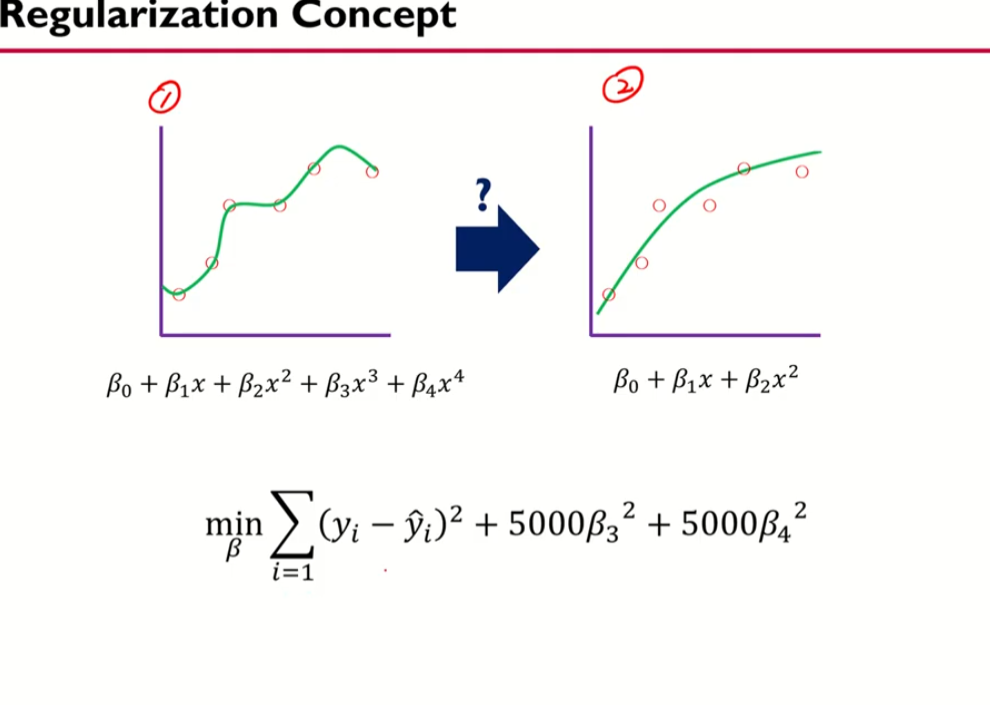

그러면 어떻게 좋은 모델로 바꿀 수 있을까?

전체 식을 최소화 시켜야한다.

최소제곱법과 비슷한 식이긴함

베타 3과 베타 4은 어떤 값을 가져야 식이 적어질까?

0에 가깝게 하면됨

따라서 파라미터에 패널티를 주는 것

제약을 주는 것 => 제약을 주었다.

혼란 스러운 것을 정돈을 했다의 개념

빨간 부분이 정규화를 시킨 것

뒷부분을 고려하지 않는다면 최소제곱법과 개념이 같다.

** 람다: 아까 5000을 곱한 값을 람다로 쓴 것

람다의 역할: 파라미터긴 함

베타도 파라미터임

람다는 하이퍼 파라미터고 레귤레이제이션을 하므로 조절 파라미터라고 함

람다를 크게하면...

전체를 최소화하기 위해서는 베타값을 0으로 해줘야함

직선의 모델이 되는 것임

람다를 작은 값을 주면 제약에 대한 효과가 없어짐

따라서 언더 피팅

트레인 데이터에 대한 에러는 적어지지만

베리언스(분산)이 커진다..

따라서 오버피팅

1번 최소제곱법

2번 레귤레이션 (정규화)

베타에대한 제약이 있냐 없냐의 차이임

1번 최소제곱법은

실제 y 예측 y의 차.

언바이어스를 맞추겠다.

베타는 고려 X

2번

베리언스를 잡겠다..

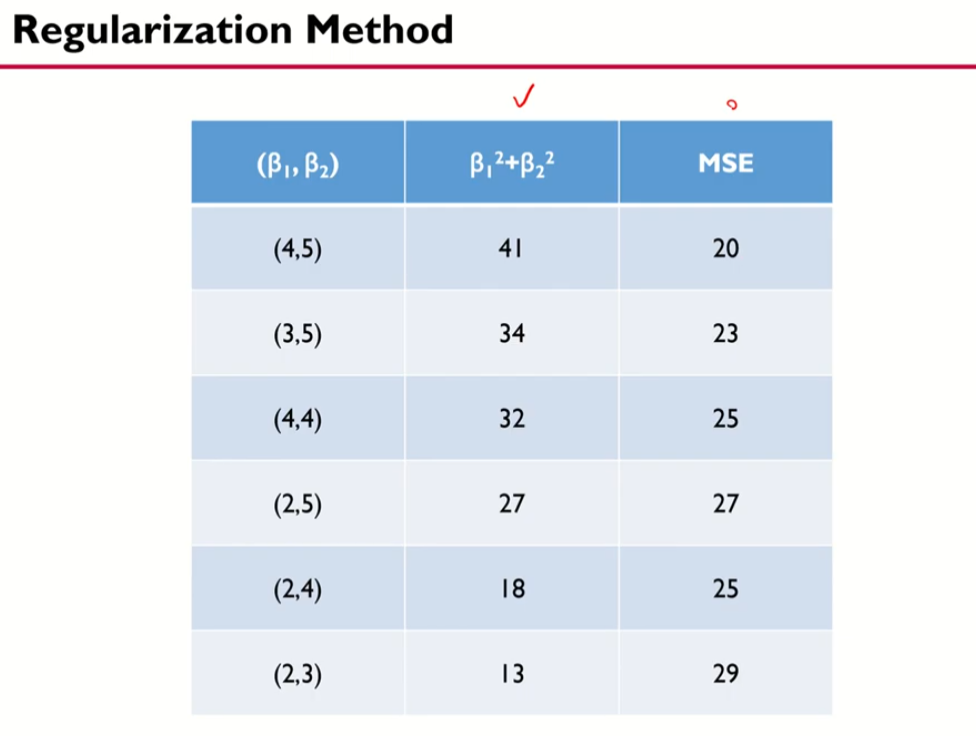

직관적인예제!

베타에 대한 제약이 없으면 제일 위에 것이 가장 좋음

제약을 걸고 나머지 세개 중에서 보면

이러한 개념을 도입한 첫번째 모델이 릿지 리그리션

L2 는 유클리드 거리(제곱)

L1 는 맨해튼 거리 (절댓값)

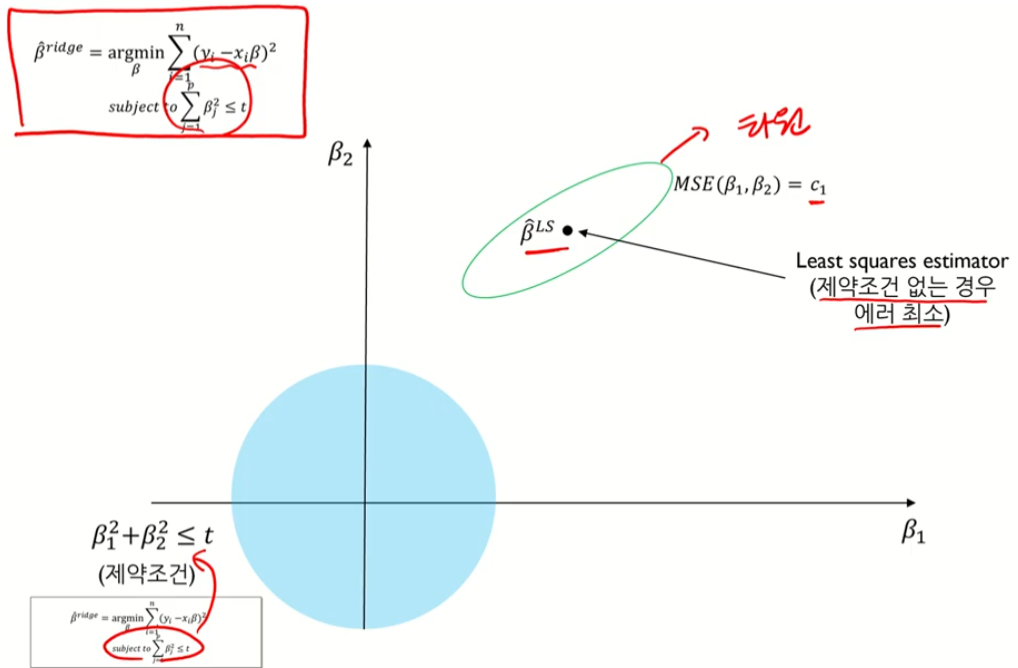

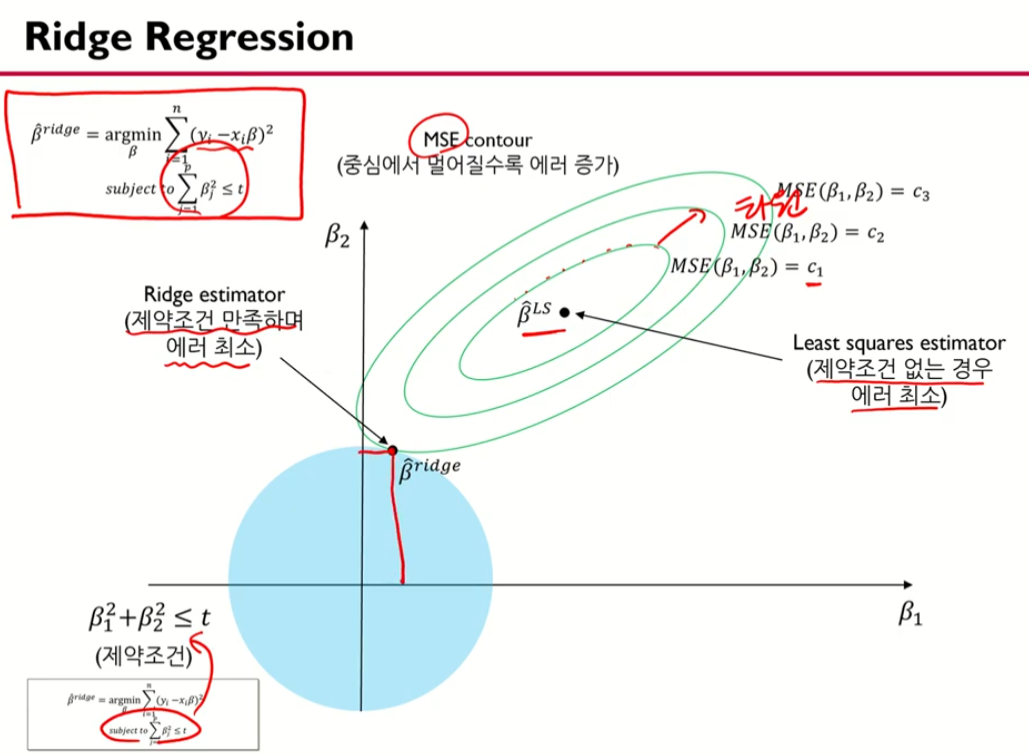

위에 것은 제약식이 있는 것

밑에 식은 t가 람다의 역할로 되어서 라그랑즈 승수법으로 제약식도 합쳐짐

코닉 이쿼션이 무엇이냐..

그럼 0보다 작은 것이면 뭘까?

타원의 값이라는 것이다..

제약이 안가면 저기있는 베타 값이 최소임

제약이 생기면 하늘 색 값이 제약이 됨

제약조건에 맞을 때 까지 키운다..

그럼 제약 조건이 맞을 때 (파란색 원과 교점이 생길 때 까지 키워나가서)

그래서 이렇게 베타 값이 옮겨졌다..

파란 원과 교점이 있는 곳으로!!

베타 값이 작아졌다 -> 슈엥키지? 방법 으로도 표현함

t값이 커지면 제약을 안가한것과 똑같음

t값을 적게하면 제약을 가한 것

t값을 너무 크게하면 최소제곱법을 가한 솔루션과 베타값이 비슷해짐

최소제곱법보다 작게해야함!!

t값을 줄일수록 점점 0이 됨ㅁ

t는 람다와 같은 역할을 함

릿지는 제곱의 형태로 패널티를 줌

최소제곱법과 릿지회귀는 비슷해보이는데 람다가 있음

람다는 하이퍼파라미터

I 는 대각행렬

unbiase

릿지에대한 통계적인 장점은 여기에 설명 X