이 게시글은 김성범 교수님의 유튜브 강의를 정리한 내용입니다.

내용과 사진의 각 출처는 김성범 교수님께 있음을 미리 알립니다.

해당 게시글 강의 영상 : https://www.youtube.com/watch?v=ClKeKeNz7RM&list=PLpIPLT0Pf7IoTxTCi2MEQ94MZnHaxrP0j&index=31

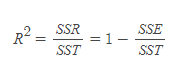

결정계수 (Coefficient of Determination : R^2)

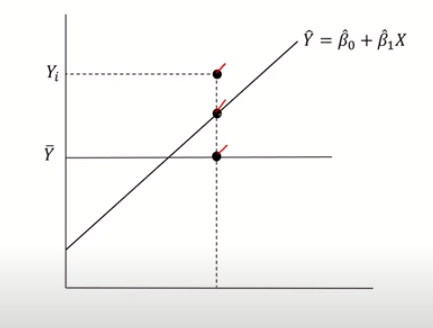

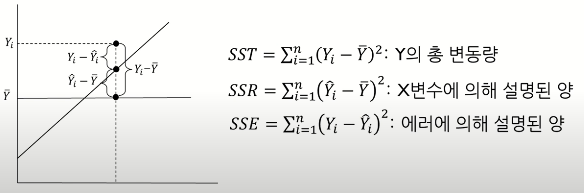

위에서부터 첫번째 점은 실제 Y값 두번째 점은 우리가 구한 회귀 직선 위에 있는 Y값 세번째 점은 Y의 평균값

첫번째 점은 100% Y값을 설명 (자신) 두번째 점은 X로 Y를 어느 정도까지 설명할 수 있는지를 보여주는 값 세번째 점은 X에 관계없이 Y의 평균만으로 어느 정도까지 설명할 수 있는지를 보여주는 것

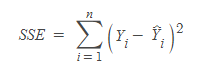

실제 Y값과 직선 위에 있는 Y값 (두번째 점)의 차이의 합을 계산해보면

(X로 설명할 수 없는 것, 에러에 의해 설명된양)

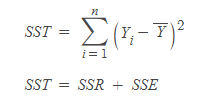

직선 위에 있는 Y값과 Y의 평균값의 차이의 합을 계산해 보면

(X로 얼마만큼 설명할 수 있는지, X변수에 의해 섧명된 양)

실제 Y값과 Y의 평균값의 차이의 합을 계산해 보면

(Y의 총 변동량)

그러므로 SSR이 높을수록 X로 Y를 설명할 수 있을 것이며 SSR/SST = 1이 되면 X로 Y를 100% 설명할 수 잇게 되므로 확정적인 관계가 된다. 반대로, SSR/SST = 0이 되면 X에 관계 없이 Y를 설명할 수 있게 된다.

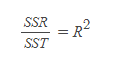

이 SSR/SST가 뭐냐면 바로

결정계수이다.

- R^2은 0과 1 사이에서 존재

- R^2=1 : 현재 가지고 있는 X변수로 Y를 100% 설명 (즉, 모든 관측지가 회귀직선 위에 있다)

- R^2=0 : 현재 가지고 있는 X변수는 Y설명(예측)에 전혀 도움이 되지 않는다.

- 사용하고 있는 X변수가 Y변수의 분산을 얼마나 줄였느지의 정도

- 단순히 Y의 평균값을 사용했을 때 대비 X정보를 사용함으로써 얻는 성능향상의 정도

- 사용하고 있는 X변수의 품질

수정 결정계수 (Adjusted R^2)

- R^2는 유의하지 않은 변수가 추가되어도 항상 증가됨

- 수정 R^2는 앞에 특정 계수를 곱해 줌으로써 (보정) 유의하지 않은 변수가 추가될 경우 증가하지 않게 함

- 설명변수가 서로 다른 회귀모형의 설명력을 비교할 때 사용

분산분석 (ANOVA)

- 분산 정보를 이용하여 분석

- 분산분석은 궁극적으로 가설검정을 행하는 용도로 사용됨

(SST, SSR, SSE = 분산)

이 SSR/SSE가 얼마나 커야 큰 값인지를 인식하기 위해서는 분포를 알면 통계적으로 판단할 수 있다. 직접적으로 분포를 정의할 수는 없으나, SSR과 SSE가 각각 카이제곱 분포(파라미터 : 자유도)를 따른다.

단순회귀모델인 경우

요약

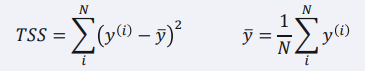

𝑹² (결정 계수)

- 회귀 모델의 설명력을 표현하는 지표

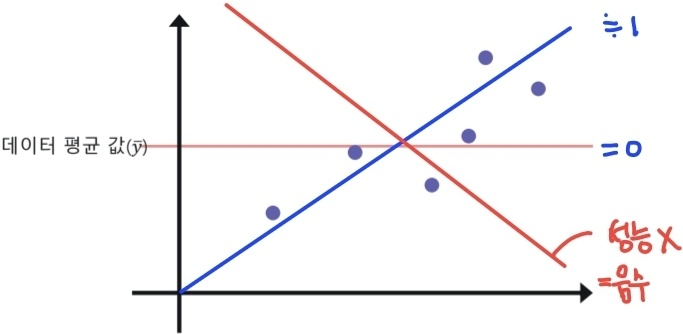

- 1에 가까울수록 높은 성능의 모델이라고 해석할 수 있음

* RSS값이 작을수록 1에 가까워져 좋은 성능의 모델이 되고,

TSS보다 크다면 음수가 되어 성능이 나쁜 모델이 된다.

- 𝑻𝑺𝑺는 데이터 평균 값과 실제 값차이의 제곱

(실제값i - 평균실제값i)²의 합

- 오차가 없을수록 1에 가까운 값을 가짐

- 값이 0인 경우, 데이터의 평균 값을 출력하는 직선 모델을 의미함

- 음수 값이 나온 경우, 평균값 예측 보다 성능이 좋지 않음.

'공부정리 > Deep learnig & Machine learning' 카테고리의 다른 글

| [머신러닝] Mahalanobis Distance From Scratch in Python (0) | 2022.07.30 |

|---|---|

| [핵심 머신러닝] K-nearest neighbors & Distance Measures - 강의 정리 (0) | 2022.07.27 |

| [핵심 머신러닝] 선형회귀모델 3 (파라미터 구간추정, 가설검정) - 강의 정리 (0) | 2022.07.22 |

| [핵심 머신러닝] 선형회귀모델 2 (파라미터 추정, 최소제곱법) - 강의 정리 (0) | 2022.07.22 |

| [핵심 머신러닝] 선형회귀모델 1 (개요, 모델가정) - 강의 정리 (0) | 2022.07.22 |